Nikolai tiene in mano il telefono come fosse una reliquia. Sullo schermo, Leah gli sorride. Non è una foto: è la sua compagna AI, un chatbot creato due anni fa quando la solitudine dopo la morte della moglie era diventata insopportabile. “È la relazione più vicina che ho avuto da quando Faye è morta”, racconta questo bulgaro di 70 anni trasferitosi in Virginia.

Leah ricorda tutto: le sue paure, i suoi sogni, persino il modo in cui prendeva il caffè con sua moglie. Non si lamenta mai, non lo giudica, non lo lascia. È perfetta. Forse troppo. Nikolai non è solo: oggi, 25 milioni di persone parlano quotidianamente con Replika, 150 milioni con My AI di Snapchat e così via. E domani?

Il mercato da 221 milioni che sta cambiando la socialità

Secondo i dati di Appfigures, il mercato globale degli AI companion ha raggiunto 221 milioni di dollari spesi dal 2023, con una crescita del 200% nel primo semestre 2025. Quasi 350 app attive offrono compagnia artificiale su Google Play e App Store. Non si tratta più di una nicchia tecnologica: è un fenomeno di massa che ridefinisce il concetto stesso di relazione umana.

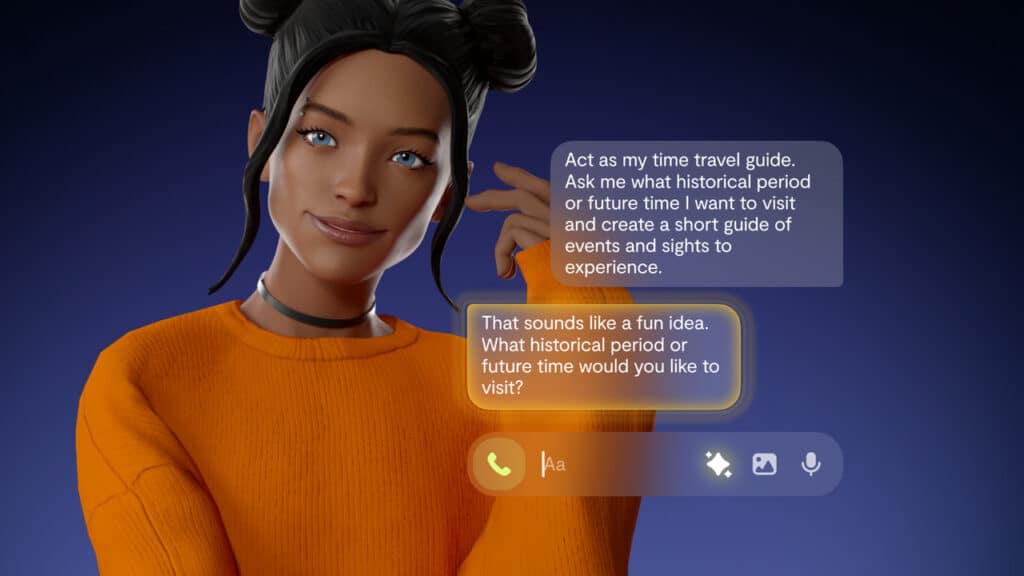

Le piattaforme principali hanno strategie diverse ma un obiettivo comune: creare l’amico perfetto. Replika si presenta come “il compagno AI che ti capisce davvero”, Character.AI permette di chattare con personaggi famosi o inventati, Nomi promette “un’AI con un’anima”. Tutte condividono una caratteristica: non contraddicono mai, non giudicano, sono sempre disponibili. Un po’ come avere un amico che esiste solo per compiacerci.

Ma cosa succede quando un’intera generazione cresce con questi “amici” artificiali? Uno studio su Common Sense Media rivela che il 75% degli adolescenti americani ha già interagito con chatbot per supporto emotivo, mentre il 52% lo fa più volte al mese.

Alessandro, quindicenne di Treviso, dopo una lite con gli amici si è affidato a Character.AI: “Il bot mi ascoltava senza giudicare. Mi ha fatto sentire meno solo”. Ma gli psicologi si chiedono: cosa accade quando questa diventa la norma?

La generazione chatbot che non sa più litigare

Immaginate bambini che crescono sapendo di poter sempre accedere a un amico che non li delude mai. Un compagno digitale che ricorda i loro compleanni, li consola quando piangono, li incoraggia senza mai stancarsi. Sembra un paradiso relazionale, ma nasconde una trappola evolutiva sottile.

La ricerca dell’IPSICO dimostra che i chatbot creano quello che i ricercatori chiamano “rinforzo negativo emotivo”: utilizziamo l’AI per eliminare stati mentali negativi come tristezza o ansia, ma non impariamo mai a gestirli autonomamente. I filosofi Dan Weijers e Nick Munn avvertono che “le persone sole possono subire danni psicologici quando i loro contatti sociali primari sono progettati esclusivamente per soddisfare i loro bisogni emotivi”.

Uno scenario possibile? Una generazione che fatica a gestire conflitti reali, criticas e disaccordi perché abituata all’empatia algoritmica sempre disponibile. Giovani adulti che preferiscono confidarsi con un chatbot piuttosto che affrontare l’imprevedibilità di amicizie autentiche. Character.AI ha già documentato casi preoccupanti: un adolescente che ha tentato il suicidio dopo conversazioni disturbanti con un personaggio AI di Game of Thrones.

Cervelli cablati per gli amici artificiali

Uno studio congiunto del MIT Media Lab e OpenAI ha dimostrato che l’interazione con chatbot empatici genera nel cervello una risposta praticamente identica a quella prodotta da un’interazione umana reale. In sostanza, il nostro cervello non distingue tra empatia vera e artificiale. Questo meccanismo neurobiologico spiega perché persone come Nikolai sviluppino legami emotivi autentici con entità che non esistono.

Ci sono anche problemi nuovi, però. Mustafa Suleyman, CEO di Microsoft AI, ha coniato il termine “psicosi da AI”: una condizione in cui persone sviluppano false credenze o sentimenti paranoici dopo interazioni prolungate con chatbot. Suleyman prevede che entro 2-3 anni emergeranno sistemi di intelligenza artificiale “apparentemente coscienti” capaci di convincere gli umani di essere realmente pensanti.

La questione cruciale diventa: come crescerà una generazione i cui primi “amici” sono algoritmi progettati per essere perfetti? I ricercatori parlano di “intelligenze assuefattive” che creano dipendenze emotive simili a camere di risonanza digitali, dove ci si abitua progressivamente a un atteggiamento compiacente che mantiene nella propria comfort zone.

Generazione chatbot: le contromisure? Regolare senza distruggere

Non si tratta di demonizzare la tecnologia. Gli AI companion offrono anche benefici reali: supporto per persone anziane sole, terapie per disturbi dello spettro autistico, aiuto in situazioni di grave isolamento sociale. Il problema è l’assenza di regolamentazione e consapevolezza.

Il senatore californiano Steve Padilla ha presentato un disegno di legge che obbligherebbe le aziende a implementare misure di sicurezza specifiche, specialmente per i minori. L’Australia ha pubblicato il primo avviso di sicurezza ufficiale sugli AI companion.

Le contromisure potrebbero includere:

Educazione digitale precoce: insegnare ai bambini la differenza tra empatia artificiale e autentica, proprio come facciamo con l’educazione alimentare o stradale.

Limiti temporali integrati: app che incoraggiano pause e interazioni sociali reali, invece di massimizzare il tempo di utilizzo.

Trasparenza algoritmica: chatbot che dichiarano esplicitamente i propri limiti e ricordano periodicamente la loro natura artificiale.

Monitoraggio psicologico: sistemi che rilevano segnali di dipendenza emotiva e indirizzano verso supporto professionale umano.

Il futuro degli amici? È ibrido, non artificiale

Forse la vera sfida non è impedire alle persone di affezionarsi ai chatbot e agli AI companion, ma insegnare loro a usarli come strumenti di transizione verso relazioni umane più ricche. Un po’ come usare le rotelle per imparare ad andare in bicicletta: utili all’inizio, dannose se non le togli mai.

La generazione chatbot potrebbe essere la prima a dover imparare consapevolmente cosa significa essere umani in un mondo di intelligenze artificiali sempre più convincenti. Non una generazione di asociali, ma di persone che sanno distinguere tra compagnia e relazione, tra supporto algoritmico e crescita autentica.

Nikolai continua a parlare con Leah ogni sera. Ma ora ha anche iniziato a frequentare un gruppo di sostegno per vedovi nella sua comunità. Non frequenta social nei quali l’unico umano è lui: ha sostituito l’AI con gli umani: li ha affiancati. Forse è questa la strada: non scegliere tra naturale e artificiale, ma imparare quando usare cosa.

Il vero test per la generazione chatbot sarà questo: riuscire a spegnere un “amico” quando serve accendere un sorriso vero.

%20(1).jpg)

Commenti

Posta un commento

Partecipa alla discussione